当前位置 > 散户吧 > 财经要闻 > 经营管理 > GPU之后,NPU再成标配,手机、PC如何承载AI大模型?

GPU之后,NPU再成标配,手机、PC如何承载AI大模型?

摘要:AI产品开发者需要先行一步,早一些让用户体验自己的产品,和用户建立连接,培养粘性,从而在竞争中占得先机。

本文来自散户吧WWW.SANHUBA.COM

2024注定是AI行业热闹非凡的一年。虽然刚刚进入3月份,但是关于AI的新闻已经多次占据了头条。就在上个月,OpenAI了文字生成视频的大模型Sora,其逼真的效果直接清空了在这个细分赛道苦苦耕耘的创业者。几天后,英伟达市值站上2万亿美元,成为了上最快实现从1万亿到2万亿美元市值的企业。正所谓“当你发现金矿,最好的生意不是挖矿而是卖铲子”,英伟达成为了AI时代“备竞赛”的最大赢家。 本文来自散户吧WWW.SANHUBA.COM

就在大家感叹“世界上只有两种AI,一种叫OpenAI,一种叫其他AI”的时候,沉寂了许久的Anthropic放出王炸,这家由OpenAI前研究副总裁创立的公司,了最新的Claude3模型,各项指标已经全面超越了GPT4。

AI行业的风起云涌,也昭示了这个行业还处在一个初级阶段。技术迭代太快,暂时领先的企业可能在一夜之间就被新技术颠覆。一些眼花缭乱的新技术,虽然已经问世,但迟迟不公开或者没有。比如上文提到的Sora,截至,还没有正式向公众开放。 本文来自散户吧WWW.SANHUBA.COM

生成式AI的研发和本地之间存在鸿沟。目前,大众使用的生成式AI产品往往是在云端而在本地访问(比如ChatGPT网页),但这无法满足所有需求,并且会产生一些隐患。

首先,随着大模型越来越复杂,云端和本地之间的传输在有限带宽下变得捉襟见肘,比如一架波音787飞机每秒钟产生5G的数据,如果上传到云端、计算、输出结果再返回,飞机可能已经飞出去几公里了(按照800公里/小时估算)。如果在飞机上使用AI功能但是在云端,这样的传输速度是无法满足要求的。 本文来自散户吧WWW.SANHUBA.COM

此外,一些用户敏感数据、隐私数据,是否一定要上云?显然放在本地比云端更让用户放心。 本文来自散户吧WWW.SANHUBA.COM

不论生成式AI多么强大,如何到本地始终是一个无法绕开的问题。这是行业发展的趋势,虽然目前面临一些困难。 本文来自散户吧WWW.SANHUBA.COM

困难在于,如何把“大模型”装入“小设备”。注意,这里的“大小”是相对而言的。云端计算的背后可能是一个占地几万平方米的计算中心,而本地却要让生成式AI在你的手机上跑起来。手机没有液氮冷却,也没有无穷无尽的电力,该如何AI呢?

异构计算,一种可能的解决方案?

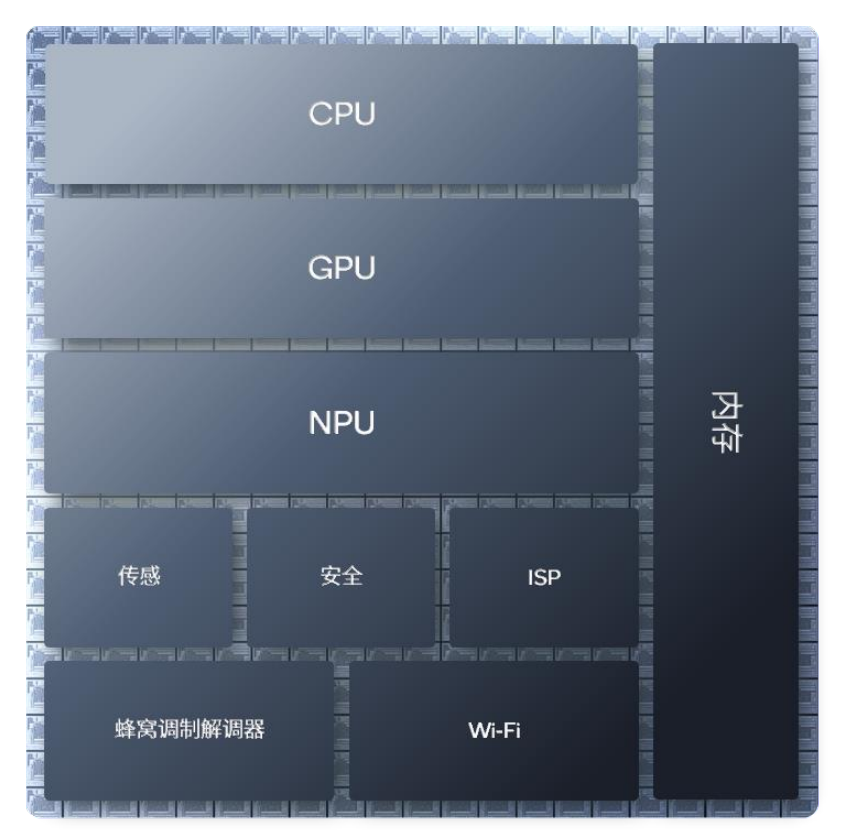

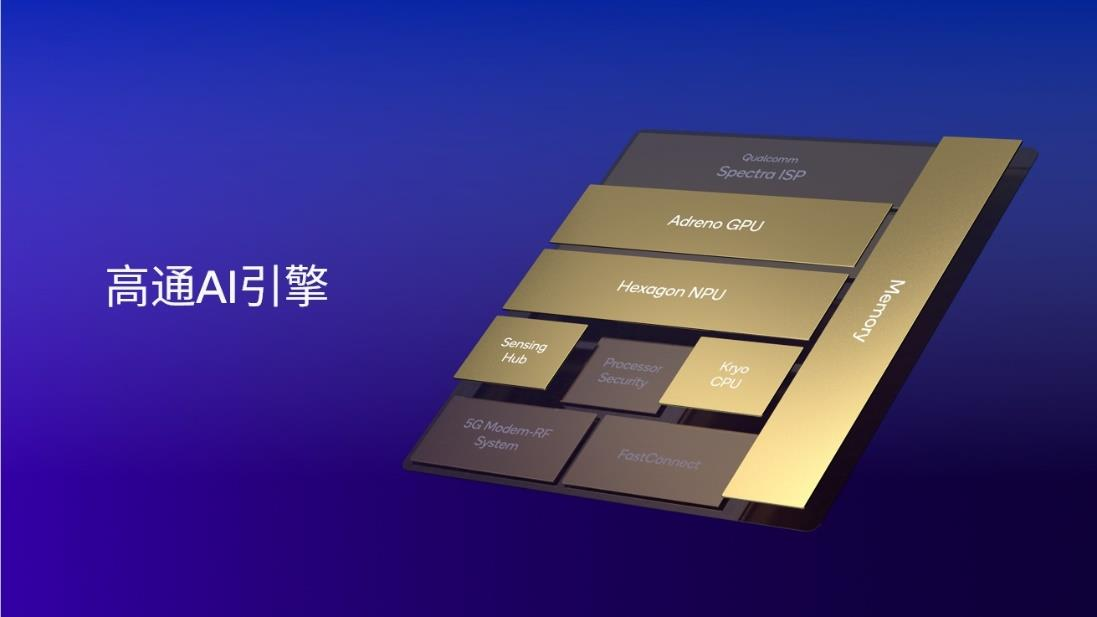

高通的异构计算AI引擎(以下皆称作高通AI引擎)为行业提供了一种可行的解决方案。即通过CPU、GPU、NPU以及高通传感器中枢和内存子系统的协作,实现了AI和大幅度提升AI体验的目的。 本文来自散户吧WWW.SANHUBA.COM

本文来自散户吧WWW.SANHUBA.COM

本文来自散户吧WWW.SANHUBA.COM

图:专门的工业设计让不同计算单元更紧凑 来源:高通不同类型的处理器所擅长的工作不同,异构计算的原理就是让“专业的人做专业的事”。CPU擅长顺序控制,适用于需要低延时的应用场景,同时,一些较小的传统模型如卷积神经网络模型(CNN),或一些特定的大语言模型(LLM),CPU处理起来也能得心应手。而GPU更擅长面向高精度格式的并行处理,比如对画质要求非常高的视频、游戏。

本文来自散户吧WWW.SANHUBA.COM

CPU和GPU出镜率很高,大众已经相当熟悉,而NPU相对而言更像一种新技术。NPU即神经网络处理器,专门为实现低功耗、加速AI推理而打造。当我们在持续使用AI时,需要以低功耗稳定输出高峰值性能,NPU就可以发挥最大优势。

举个例子,当用户在玩一款重负载的游戏,此时GPU会被完全占用,或者用户在浏览多个网页,CPU又被完全占用。此时,NPU作为真正的AI专用引擎就会负担起和AI有关的计算,保证用户的AI体验流畅。

本文来自散户吧WWW.SANHUBA.COM

总结起来说就是,CPU和GPU是通用处理器,为灵活性而设计,易于编程,本职工作是负责操作系统、游戏和其他应用。NPU则为AI而生,AI是它的本职工作,通过牺牲部分易编程特性而实现了更高的峰值性能和能效,一路为用户的AI体验护航。

当我们把 CPU、GPU、NPU 以及高通传感器中枢和内存子系统集成在一起,就是异构计算架构。

本文来自散户吧WWW.SANHUBA.COM

本文来自散户吧WWW.SANHUBA.COM

本文来自散户吧WWW.SANHUBA.COM

高通AI引擎整合了高通 Oryon 或 Kryo CPU、 Adreno GPU 、 Hexagon NPU 以及高通传感器中枢和内存子系统。Hexagon NPU作为其中的组件,经过多年的升级迭代,目前已达到业界领先的AI处理水平。以手机平台为例,集成高通 AI 引擎的第三代骁龙 8 支持行业领先的LPDDR5x内存,频率高达4.8GHz,使其能够以非常高速的芯片内存读取速度运行大型语言模型,如百川、Llama 2等,从而实现非常快的token生成速率,为用户带来全新的体验。

本文来自散户吧WWW.SANHUBA.COM

(小编:财神)

相关新闻更多新闻>>

- ·通心络治疗急性心梗循证研究入选“2023心血管领域十大亮点”01-14

- ·冬奥连冬运 草原向北京 万里茶道自驾行系列活动在首钢园成功举办启动仪式09-27

- ·微粒贷支持随借随还,提前还款没有违约金12-21

- ·恒尚节能上市时间消息 公司什么时候上市?04-10

- ·对话新乳业总裁朱川:未来几年是优胜劣汰的深度调整期,决定品牌走多远12-29

- ·新威凌是什么所上市?新威凌上市新消息11-24

- ·点亮高质量发展新赛道,光明乳业亮相第十四届中国奶业大会07-27

- ·中芯集成业绩怎么样?净利润多少钱?04-19

- ·李文亮妻子发声明:拒绝个人或团体机构捐助02-09

- ·因赛集团代表选手获得戛纳旗下Young Spikes PR类别金奖03-10

今日要闻更多>>

- ·A股申购|星宸科技迎来申购,申购代码是多少?03-13

- ·金龙鱼属于食品粮油加工板块吗?(2024/3/12)(名单)03-13

- ·你值得关注的a股2024年混晶涂覆材料股票(干货分享)(3月12日)03-13

- ·速看!高速铁路相关概念股票名单(3月12日)03-13

- ·来看看A股沉侵式液冷系统概念股名单(3月12日),有你的吗?03-13

- ·过滤袋概念股名单(2024/3/12),有你的吗?03-13

- ·骏鼎达明日申购开启,中签号什么时候公布?03-13

- ·淘气天尊:创业板大涨4.60%,明天或将明显分化!03-13

- ·AI发展给电力供应带来压力 国产变压器出海空间广阔03-13

- ·股民必看!2024年手机概念股龙头精选名单(3月4日)03-13

财经要闻更多>>

- · 李云泽:完全有信心、有条件、有能力维护国家金融安全03-13

- · 俞建华:初步判断上半年我国外贸基本保持在增长通道03-13

- · 孙业礼:对外国游客入境便利性进行全流程梳理优化03-13

- ·景嘉微:研发成功 AI智算模块及整机03-13

- ·昔日房地产龙头宣布:全部退出03-13

- ·三月开盘?2024年3月8日股市开市时间是什么?03-13

- ·海大集团:使用合计5.3亿元闲置自有资金购买两款结构性存款产品03-13

- ·仁和药业:玻璃酸纳滴眼液获药品注册证书 有助于提升公司产品市场竞争力03-13

- ·金刚光伏:为满足日常运营需要 拟抵押子公司资产借款2.75亿元03-13

- ·GPU之后,NPU再成标配,手机、PC如何承载AI大模型?03-13